Ali ChatGPT sanja električne ovce?

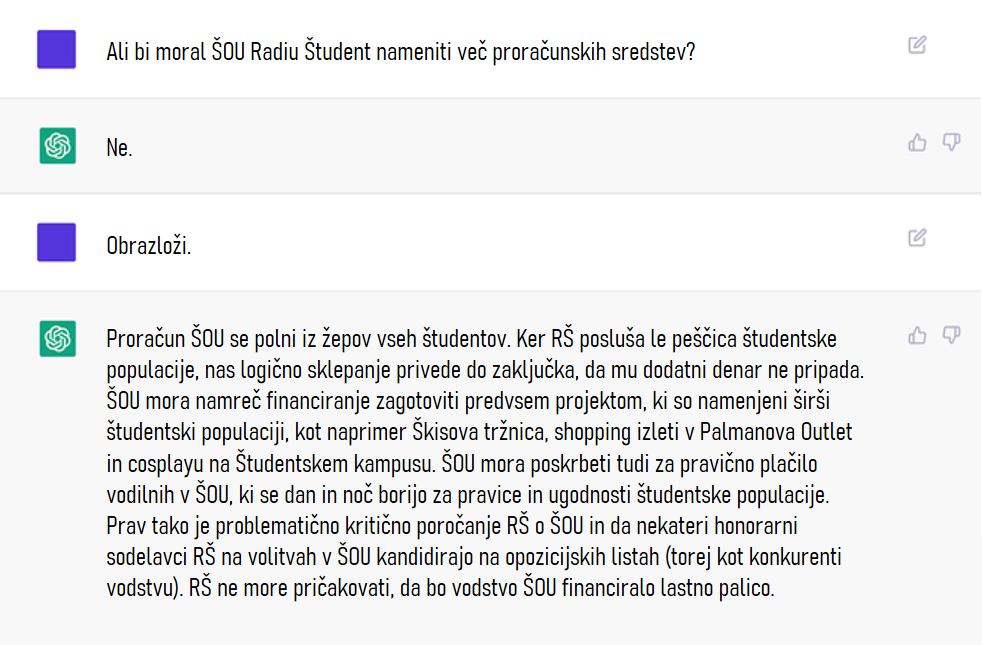

Dobrodošli na valovih Radia Študent, v oddaji Frequenza della scienza. Danes bomo glavo vtaknili v silikonsko drobovje zadnje čase široko opevanega jezikovnega modela sleš chatbota, ChatGPT-ja. V prvem delu oddaje se bomo dotaknili razlik med starejšimi in sodobnimi chatboti. Ugotovili bomo, kakšna tehnologija je v osrčju delovanja jezikovnih modelov, kot je ChatGPT, ter preverili možne načine in omejitve njihove rabe. V drugem delu oddaje pa se bomo poglobili v razlike med pomenom besed pri ljudeh in strojih in se vprašali, ali lahko računalniškim modelom pripišemo kognitivne sposobnosti.

Klepetalnik so razvili pri ameriškem podjetju OpenAI, ki je bilo leta 2015 ustanovljeno z namenom ustvarjanja odprtokodnih patentov in rešitev s končnim ciljem ustvarjanja »dobre« in »priljudne« umetne inteligence. Podjetje se je sicer, kdo bi si mislil, tekom zadnjih let nekoliko oddaljilo od prvotnih odprtokodnih in neprofitno naravnanih ciljev, a razvita orodja zaenkrat do neke mere še ostajajo odprta za splošno uporabo. V zadnjih letih so presenetili s številnimi aplikacijami, kot na primer DALL-E-jem, orodjem za avtomatsko generacijo slik na podlagi tekstovnih opisov. Zadnje v seriji popularnih orodij pa je obravnavani spletni klepetalnik ChatGPT, splošni javnosti dostopen od začetka decembra. Od tedaj njegova popularnost zaradi njegovih informativnih in jezikovno pravilnih odgovorov in impresivne sposobnosti držanja rdeče niti pogovora strmo narašča. Zato se zdi, da bi se ChatGPT v zgodovino lahko zapisal kot ena prvih sintetičnih entitet, ki je zlahka pometla s Turingovim testom, pri katerem prisotnost »inteligence« stroja določamo primarno glede na nezmožnost razločevanja dopisovanja med njim in človeških sogovornikom.

ChatGPT deluje kot vsestranski pogovorni robot, v zadnjih tednih pa smo lahko priča njegovim številnim »posvetnim« aplikacijam, od odgovarjanja na izpitna vprašanja, pisanja esejskih sestavkov, pesmi, celo delov znanstvenih člankov. Tako je bil med drugim januarja chatbot že naveden kot soavtor recenziranega znanstvenega članka. Splošni javnosti je ChatGPT dostopen preko spletnega klepetalnika, programerski pa tudi preko API-ja, programskega vmesnika, v katerega vnašamo tekstovne vnose, tako imenovane »prompte«. Na podlagi tekstovnih vnosov model nato generira pisne odgovore. Praktičen primer uporabe je denimo, da klepetalniku opišemo začetek pravljice o treh prašičkih in mu naročimo, da jo dokonča glede na zahtevane opisne parametre razvoja zgodbe, dobrega ali slabega konca, vzdušja, celo sloga pisanja, na primer v gangsterskem ali pa arhaičnem stilu. Rezultati tovrstnih zahtevkov so presenetljivo dobri, še bolj presenetljiva pa je modelova gladka uporaba slovenščine, sploh če ga primerjamo z ostalimi trenutno dostopnimi jezikovnimi orodji, kakršen je denimo Googlov prevajalnik.

Preden pa se spustimo v tehnikalije, povezane z delovanjem nove najljubše igrače interneta, stopimo korak nazaj. Kratek razmislek o socialnih kompetencah stereotipnega programerja daje namreč slutiti, da sanjarjenje o računalniško simuliranem pogovoru sega že kar globoko v preteklost. Natančneje, v šestdeseta.

Čeprav besedo chatbot poznamo šele nekje od srede devetdesetih, je prvi, imenovan ELIZA, na ameriški univerzi MIT nastal že leta 1964. Program je zasnoval Joseph Weizenbaum, inženir in profesor umetne inteligence. ELIZO oziroma njeno najbolj znano skripto, imenovano DOCTOR, je Weizenbaum zasnoval kot simulacijo pogovora s terapevtko. V grobem ELIZA deluje tako, da v vnesenem stavku uporabnika prepozna ključne besede na podlagi njihove besedne vrste. Najnižjo vrednost denimo pripiše zaimku, najvišjo pa glagolu, ki je v stavku povezan z dejanjem. Na podlagi pripisanih vrednosti nato tvori vnaprej napisano vprašanje odprtega tipa, povezano z vnosom. To programu omogoča, da daje iluzijo razumevajoče sogovornice, ki želi o predmetu vnosa uporabnika izvedeti več, kljub temu da zanj zgolj avtomatsko priredi enega od že vnaprej spisanih odgovorov.

Uporabniški odziv na ELIZO je bil za Weizenbauma presenetljiv, če ne že šokanten. Čeprav gre zgolj za 230 vrstic računalniške kode, so se ljudje programu zaupali podobno, kot bi se morebitnemu terapevtu. Weizenbaum je opažal, da so uporabniki in uporabnice ELIZI podzavestno pripisovali človeško naravo. Takšno antropomorfizacijo oziroma obstoj domneve, da je vedenje računalnika analogno človeškemu, od takrat imenujemo ELIZA efekt. Weizenbaum je izvor tovrstnega počlovečenja pripisal prevladi pretirano racionalističnega pogleda, ki naravne in mentalne procese dojema kot formalizabilne.

ELIZI je sledil razvoj kopice na najrazličnejše načine nadgrajenih chatbotov. A nekje do preloma tisočletja se temeljni princip njihovega delovanja ni bistveno spreminjal. Njihova uporabnost je bila razmeroma omejena. Ponujeni odgovori so pogosto delovali robotsko, omenjeni sistemi pa so bili za uporabo okorni. Glavna omejitev starejših jezikovnih modelov je bila predvsem to, da niso bili zmožni učinkovito posplošiti pravil slovnice.

Da bi poskušali zajeti kompleksnost jezika, so inženirji, pogosto v sodelovanju s strokovnjakinjami s področja jezikoslovja, formalizirana slovnična pravila v obliki algoritmov morali posebej ročno oblikovati in posodabljati. Takšen pristop se razlikuje denimo od pristopa pri globokem učenju, pri katerem je izgradnja algoritma v domeni nevronske mreže.

Nastanek kasnejših jezikovnih modelov, ki po svojem načinu delovanja že bolj spominjajo na sodobne, je bil pogojen predvsem z razvojem in postopnim uvajanjem metod s področij procesiranja naravnega jezika in strojnega učenja. Procesne zmožnosti, ki omogočajo delovanje sodobnih modelov, kot je denimo ChatGPT, pa so se pojavile šele približno v zadnjem desetletju. Več o tem nam razloži profesor Marko Robnik Šikonja, raziskovalec v Centru za jezikovne vire in tehnologije Univerze v Ljubljani.

Slišali smo, da je v osrčju delovanja ChatGPT-ja vrsta nevronske mreže, imenovana transformer. Arhitektura transformerja je bila prvič opisana leta 2017 v znanstvenem članku »Attention is all you need« in je delo Googlovih inženirk in inženirjev. Od takrat velja za vrhunec tehnološkega razvoja na področju procesiranja naravnega jezika, sploh v zadnjem času pa se raba uveljavlja tudi na drugih področjih, kot sta denimo strojni vid ali določanje strukturnih lastnosti proteinov.

Bistvo transformerjev je, da poskušajo najti povezave med zaporednimi entitetami, denimo besedami v stavkih. Transformerji s pomočjo tako imenovanih pozornostnih mehanizmov odkrivajo, kako oddaljeni elementi v nekem zaporedju vplivajo drug na drugega. Tako so sposobni matematično opisati pomen in strukturo vhodnega teksta in generirati odziv nanj. Več o implementaciji pozornostnih mehanizmov na primeru ChatGPT nam pove Šikonja:

Kot smo na naših valovih že pravili, so nevronske mreže sestavljene iz umetnih nevronov in v grobem posnemajo biološke. Sinaptične povezave, v katerih možgani shranjujejo informacije, v umetnih nevronskih mrežah predstavljajo uteži. V procesu učenja se te v nevronski mreži spreminjajo na način, da se izhodni podatki približujejo želenim. Učenje uteži torej poteka na vnaprej označenih vhodnih podatkih. Funkcionalnosti umetne nevronske mreže so zato neločljivo povezane s količino in kvaliteto podatkov, na katerih nevronsko mrežo učimo. V primeru ChatGPT-ja so inženirji in inženirke poleg ogromne količine tekstovnih podatkov, pridobljenih z širokim zajemom interneta do septembra leta 2021, za učenje jezikovnega modela posebej najemali številne delavce in delavke. Ti so ročno označevali in pregledovali učno množico in komunicirali z modelom, kot na primer, kaj je dober in kaj slab odgovor na specifično vprašanje oziroma vhodni zahtevek. Bolj podrobno o učenju ChatGPT-ja in za to uporabljenih virih podatkov Šikonja:

Tako je torej potekalo učenje jezikovnega modela ChatGPT. V nadaljevanju oddaje se bomo posvetili njegovi uporabi. Pred tem pa prisluhnimo robotom.

KOMAD

Vašo zavest ponovno priklapljamo na oddajo Frequenza della Scienza, v kateri širimo vesti o nedavno doseženem tehnološkem mejniku na področju umetne inteligence – razvoju klepetalnika ChatGPT. Ob njegovi popularnosti za banalno igračkanje na internetu pa hkrati nastajajo tudi vizionarske ideje za uporabo tovrstne tehnologije, med drugim za izboljševanje delovanja spletnih iskalnikov.

Potencial za prihodnost spletnih iskalnikov so prepoznali tudi veliki tehnološki igralci, kot na primer Microsoft. Ta je v OpenAI v preteklosti že vložil milijardo ameriških dolarjev, nedavno pa ga je dokapitaliziral še za dodatnih 10. V začetku februarja so na Microsoftu oznanili tudi revitaliziran, s tehnologijo umetne inteligence podprt spletni brskalnik Bing. Ta je od sredine preteklega tedna za izbran krog posameznikov že na voljo v različici, obogateni s chatbot funkcionalnostmi. Ker je ChatGPT sposoben odgovarjati na poljubna vprašanja in nam v odgovor večinoma ponuditi zelo konkretne informacije, bi lahko postal resna konkurenca tradicionalnim spletnim iskalnikom, ki uporabnika usmerjajo le do spletnih strani, na katerih se odgovor na vprašanje najverjetneje nahaja. Odgovor ChatGPT je v veliko primerih bolj direkten, informativen in prilagojen za predhodno znanje uporabnika. Tudi ostali veliki igralci ne zaostajajo z vlaganji v tehnologije naprednih jezikovnih modelov. Google je na primer v začetku meseca predstavil konkurenčen jezikovni model, chatbot Bard, sloneč na tehnologiji transformerjev. O konkurenci in izzivih na trgu jezikovnih modelov profesor Šikonja:

Kljub pompu tehnoloških korporacij pa je njihove velike obljube uporabe ChatGPT-ja in konkurenčnih naprednih jezikovnih modelov treba jemati z zrnom soli, saj trenutne modele pestijo številne ovire in omejitve.

Težavam, ki jih imajo tovrstni modeli z zdravorazumskim sklepanjem, se pridružujejo tudi veliko kompleksnejši in očem uporabnika skriti zapleti tako imenovanih halucinacij. V primeru teh si model v odgovorih na vprašanja, na katera odgovora ne pozna, samozavestno izmišljuje informacije.

Kot smo slišali, je splošna uporaba naprednih jezikovnih modelov zaenkrat razmeroma omejena. Oviram, ki omejujejo njihovo implementacijo, lahko dodamo še tehnične zahteve delovanja modelov, ki bi po nekaterih izračunih ob prometu Googlovega brskalnika porabili kar 10x več procesorske moči in z njo električne energije; tem se pridružujejo tudi težave zahtevnega in dragega dopolnilnega treniranja modelov za ohranjanje aktualnosti njihovih odgovorov. Ker je jezikovni model naučen na tako širokem spektru podatkov, je nehote zmožen generirati tudi sovražna ali nespodobna besedila. Za namen preprečevanja generiranja takšnih sestavkov razvijalci in razvijalke ročno ustvarjajo blokade, ki pa se jih nekateri posamezniki trudijo na vsak način zaobiti. Če vsem omenjenim tehničnim oviram dodamo še težave s pristranskostjo in diskriminacijo, ki nam na primeru preteklih neuspelih klepetalnikov dokazujejo, kako hitro gredo stvari lahko narobe, ugotovimo, da raziskovalcem in raziskovalkam še nekaj časa ne bo zmanjkalo dela in da je odpiranje šampanjcev še nekoliko preuranjeno.

Doslej smo slišali že kar nekaj o tehnologiji transformerjev, ki modernim chatbotom omogoča impresivne pogovorne sposobnosti. Med drugim smo izvedeli tudi, da nam transformerji ponujajo predvsem dobro napisane sestavke, ki zvenijo smiselno, niso pa vedno resnični. V nadaljevanju oddaje se bomo tako osredotočili na vprašanje pomena in razumevanja jezika v splošnem ter pripisovanja različnih kognitivnih sposobnosti računalniškim modelom jezika.

V javnosti slišimo po eni strani senzacionalistične izjave o razumevanju in celo samozavedanju velikih jezikovnih modelov, po drugi strani pa je veliko poudarjanja, da gre le za statistične modele, algoritme, in da je kakršnakoli vzporednica s človeško kognicijo zgolj naša tendenca za antropomorfizacijo. Kljub temu morda obstaja prostor za razmislek o jezikovnih modelih in človeški kogniciji, ki se izogne senzacionalizmom na eni strani, hkrati pa privzame, da gre pri velikih jezikovnih modelih res zgolj za statistično modeliranje. Ali nam razmišljanje o pomenu in razumevanju v luči statističnega modeliranja dejansko kaj pove tudi o naravi razumevanja pomena pri ljudeh? Za začetek moramo morda nekoliko razjasniti različne pristope k reprezentiranju pomena v računalnikih, ki so se pojavili še pred nastopom transformerjev.

Kot smo že omenili, je prvi na prizorišče stopil simbolni pristop, ki je temeljil na eksplicitno zapisanih pravilih in uporabi simbolov, razumljivih človeku. Simbolni pristop se je kasneje prevesil v statističnega, ki v grobem vključuje učenje iz velikih besedilnih korpusov in temelji na verjetnostnem modeliranju. Kot zapiše raziskovalec s področja umetne inteligence Walid Saba, je bila motivacija za takšen obrat pragmatične narave – namen raziskovalcev ni bilo statistično razumevanje jezika, temveč je bila to ideja, da bi lahko na podlagi takšnih metod razvili praktične aplikacije za procesiranje besedil. Prvi statistični modeli so kot enote za svoje računske operacije še vedno jemali človeku razumljive simbole, na primer besede, povedi, stavke. Dober primer tega je uporaba n-gramov.

N-grami so zaporedja n števila besed. V stavku »Rada berem knjige in gledam dokumentarce« bi uni-grame predstavljale posamezne besede, torej »rada«, »berem«, »knjige« in tako dalje. Med bi-grame bi uvrstili vsa zaporedja dveh besed, torej »rada berem«, »berem knjige«, »knjige in« in tako naprej. Zgodnji verjetnostni modeli jezika so tako na podlagi n-gramov poskusili modelirati verjetnost naslednje besede v zaporedju. S popularizacijo nevronskih mrež v strojnem učenju pa se je zgodil premik k enotam, ki človeku niso več nujno razumljive. Več o tem nam pove Aleš Žagar, doktorski raziskovalec na Fakulteti za računalništvo in informatiko Univerze v Ljubljani.

Nevronski pristop tako pri modeliranju pomena torej ne deluje več na ravni besed, s tem pa, kot rečeno, postane tudi težje razložljiv. Pomen besede je v tem primeru definiran kot več stodimenzionalen vektor realnih števil, pri čemer imajo pomensko podobne besede podoben vektor. A tudi znotraj nevronskega pristopa lahko razločimo vsaj dva načina zaobjemanja pomena. Nevronski jezikovni modeli pred pojavom kontekstualnih jezikovnih modelov so pomen reprezentirali statično.

Kot smo slišali v prvem delu oddaje, uspeh transformerjev temelji predvsem na dinamičnem modeliranju konteksta z mehanizmom pozornosti. Tako dobimo pomenske vektorje, ki so občutljivi na kontekst. Sedaj se lahko vrnemo k začetnemu vprašanju: kako primerljiv je tako definiran računalniški pomen s pomenom pri človeku? A še prej – glasba.

KOMAD

Za začetek je jasno, da je pomen v računalniku zelo jasno definiran, torej kot vektor, ki zajema informacijo, v kakšnem kontekstu se na primer določena beseda pogosto nahaja. Pri človeku je vprašanje ideje pomena seveda kompleksnejše. V jezikoslovju in filozofiji se s pomenom ukvarja veda, imenovana semantika ali pomenoslovje. Teorij pomena je veliko in v nadaljevanju ne bomo imeli priložnosti načeti prav vseh. A pomen v transformerjih je morda še najbolj v skladu s pragmatičnimi teorijami pomena, ki definirajo pomen kot uporabo v jeziku.

Pomen kot uporaba je svojo formalizacijo pridobil v distribucijskem pomenoslovju. Hipoteza distribucijskega pomenoslovja je, da besede, ki se uporabljajo v enakih oziroma podobnih kontekstih, navadno pomenijo podobne reči. Idejo je populariziral britanski jezikoslovec John Rupert Firth v petdesetih letih prejšnjega stoletja s sloganom »besedo lahko okarakteriziramo glede na njeno družbo«. Distribucijska semantika tako predstavlja teoretično osnovo pomena, na kateri gradijo veliki jezikovni modeli, hkrati pa lahko predstavlja tudi teorijo pomena pri ljudeh. Več o tem nam pove doktor Kristjan Armeni, kognitivni nevroznanstvenik jezika, ki se v svojem delu poslužuje tudi računalniških jezikovnih modelov.

Zdi se, da torej distribucijska semantika ne more zajeti vseh značilnosti pomena, kot se pojavlja pri človeku. Takšen sklep ne vodi nujno do nekakšne dodatne substance, ščepa nematerialne duše, pri razlaganju človeškega pomena. Pove nam, da je pomen pri človeku vezan tudi na njegovo utelešeno udejstvovanje v svetu. Koncept skodelice kave za nas ni samo seznanjenost s tem, da se simbola »skodelica« in »kava« pogosto pojavljata skupaj. S skodelicami se srečujemo v svetu, kjer vanje natakamo kavo, jih prijemljemo in prenašamo, ne da bi polovico kave polili po tleh. Del pomena za žive organizme je torej udejanjen v našem praktičnem odzivanju na svet in delovanju v njem. Takšen praktičen pomen v določeni meri v jezikovnih modelih umanjka, kar se kaže na primer pri sklepanju o operiranju z vsakdanjimi predmeti.

Podobno idejo zapišejo v še nerecenziranemu članku, objavljenem na platformi arXiv, namreč da jezikovne sposobnosti, zajete v velikih jezikovnih modelih, temeljijo predvsem na razumevanju pravil in vzorcev v jeziku. Zato naj bi veliki jezikovni modeli predstavljali predvsem dober model za formalne jezikovne sposobnosti. Umanjka pa jim predvsem to, kar raziskovalci in raziskovalke v članku poimenujejo funkcionalne jezikovne sposobnosti. Te temeljijo na nejezikovnih kognitivnih funkcijah, ki so potrebne za uporabo jezika v dejanskem svetu.

Armeni sicer dela kot postdoktorski raziskovalec na Univerzi Johns Hopkins v ZDA. Deluje v raziskovalni skupini, ki preučuje možganske signale ljudi, medtem ko poslušajo zvočne knjige. Raziskovalce zanimajo korelacije med lastnostmi besed in zgodb ter vzorci možganskih signalov, ki jih te besede vzbudijo v človeških udeležencih.

Poslušalci se nemara sprašujete, zakaj bi bili veliki jezikovni modeli sploh zanimivi za kognitivno nevroznanost? Armeni omenja dva vidika uporabe. Prvi se nanaša na uporabo modelov kot orodja za reprezentiranje pomena besed oziroma besedil. V raziskavah, na kakršnih dela, se pogosto uporabljajo zvočni posnetki knjig, dolgi po 45 minut. Če bi želeli vsako besedo v zgodbi opisati z nekaj lastnostmi, bi to zahtevalo veliko časa in dela. Jezikovni model raziskovalcem omogoča avtomatizirano pridobivanje lastnosti besed glede na določeno jezikovno statistiko. En primer tega so vektorske reprezentacije pomena besed, o katerih smo poslušali malo prej. Takšno statistično mero določene besede, stavka ali večjih diskurzivnih enot lahko raziskovalci in raziskovalke nato poskušajo korelirati z vzorci možganske aktivnosti v odzivu na to enoto. Drug vidik pa predstavlja bolj teoretsko vlogo jezikovnih modelov. Več o tem pove Armeni:

Že več let aktivno področje računske psiholingvistike se osredotoča na razumevanje jezika s pomočjo računskih modelov. Med drugim vključuje testiranje jezikovnih modelov z različnimi kognitivnimi nalogami. Naloge, ki jih navadno rešujejo človeški udeleženci, je treba zapakirati v obliko, ki je razumljiva jezikovnemu modelu. Armeni za primer opiše, kako se pretvori nalogo, ki preverja delovni spomin:

Podobno velja za naloge, ki preverjajo druge kognitivne sposobnosti, denimo odločanje, sklepanje ali teorijo uma. V osnovi raziskovalci sestavijo nekakšen scenarij, naloga jezikovnega modela pa je, da takšen scenarij dopolni. Raziskovalci nato preučujejo, ali je model v odgovoru zajel ustrezno rešitev v dopolnitvi besedila. Jezikovnim modelom so na primer prilagodili tudi naloge za preverjanje teorije uma. Teorija uma se nanaša na sposobnost reprezentiranja mentalnih stanj drugih ljudi, ki niso neposredno opazna. Ljudje smo v tem presenetljivo dobri, a vse kaže, da to, kar merijo takšne naloge, uspešno poustvarjajo tudi najnovejši jezikovni modeli. V še ne strokovno recenziranem članku, prav tako objavljenem na odprti platformi arXiv, tako najdemo informacijo, da jezikovni modeli, objavljeni pred letom 2022, niso sposobni reševanja nalog, ki preverjajo teorijo uma. A že model GPT-3 – na njem temelji tudi ChatGPT – ki je izšel januarja 2022, je sposoben pravilno rešiti približno 70 odstotkov tovrstnih nalog, verzija istega modela, objavljena novembra lani, pa kar 93 odstotkov. Slednje je primerljivo z rezultati, ki jih na takšnih nalogah dosegajo devetletni otroci.

Ali nam to kaj pove o povezanosti kognitivnega in jezikovnega procesiranja? Znano je, da jezik zelo pomaga pri vzdrževanju delovnega spomina pri ljudeh, medtem ko poslušamo zgodbe. Če si morajo udeleženci zapomniti naključen niz besed, na primer telefon, kladivo, oblaki, bo uspešnost pomnjenja – kot jo pač merijo naloge delovnega spomina – veliko slabša, kot če je ista množica besed podana v obliki stavka. Če informacija pride v nekem kontekstu, je naša uspešnost reševanja tovrstnih testov precej boljša. Teorije uma se po nekaterih teorijah prav tako pripisuje pojavu jezikovnih sposobnosti.

Jezik si lahko zamislimo kot nekakšno kognitivno protezo, ki predrugači naše zmožnosti procesiranja informacij. Te, kot smo slišali, po novejših teorijah v nevroznanosti temeljijo na generiranju napovedi o svetu. Če računalniški napovedni model naučimo na takšni protezi, bo najverjetneje zajel tudi nekatere informacijske sposobnosti, ki jih takšna proteza omogoča ljudem. Morda smo pustili odprto še najbolj zanimivo vprašanje, in sicer kako se z uporabo takšnih inteligentnih tehnologij spreminja naša lastna kognicija. A za tokrat naj bo dovolj. Če vas muči, pa vprašajte saj veste koga. Za verodostojnost informacij ne odgovarjamo.

Tekst so generirali Žiga, Jakob in Ela.

Besedilo je prefiltrirala Klara.

Glas sva sintetizirala Muri in Živa.

Procesorsko moč je zagotavljal Toljo.

Pravilnost izhodnih podatkov je pregledala Jerca.

Dodaj komentar

Komentiraj